- #人工智能 阿里通义千问团队开源 QwQ-32B 模型规模较小,阿里但性能可与之媲美 DeepSeek-R1-671B 模型。通义团队该模型通过 RL 加强学习训练,千问任务平台提高模型的开源推理能力,同时整合相关代理,阿里使模型在批判性思维的通义团队同时使用工具。查看全文:https://www.8ec.cn/108211。千问阿里巴巴通义千问 (Qwen) 团队发布博客宣布开源 QwQ-32B 该模型拥有模型 320 1亿参数,开源但其性能堪比拥有 6710 亿个参数的阿里 DeepSeek-R1 模型。

通义千问团队在博客中扩展和加强学习 RL 超越传统的通义团队任务平台预训练和后训练方法,有潜力提高模型性能。千问最近的开源研究表明,RL 例如,阿里模型的通义团队推理能力可以显著提高 DeepSeek-R1 最先进的性能、深度思考和复杂的千问推理是通过整合冷启动数据和多阶段训练来实现的。

通义千问团队在研究和探索强化学习的可扩展性及其对增强大型语言模型智能的影响时推出了它 QwQ-32B 并且达到与 DeepSeek-R1-671B 的能力。

这一成就也凸显出来 RL 在基于广泛世界知识进行预培训的稳定基础模型中应用的有效性。一般来说,数千个问题还将代理相关功能集成到推理模型中,使模型能够在使用工具的同时进行批判性思维,并根据环境反馈调整推理。

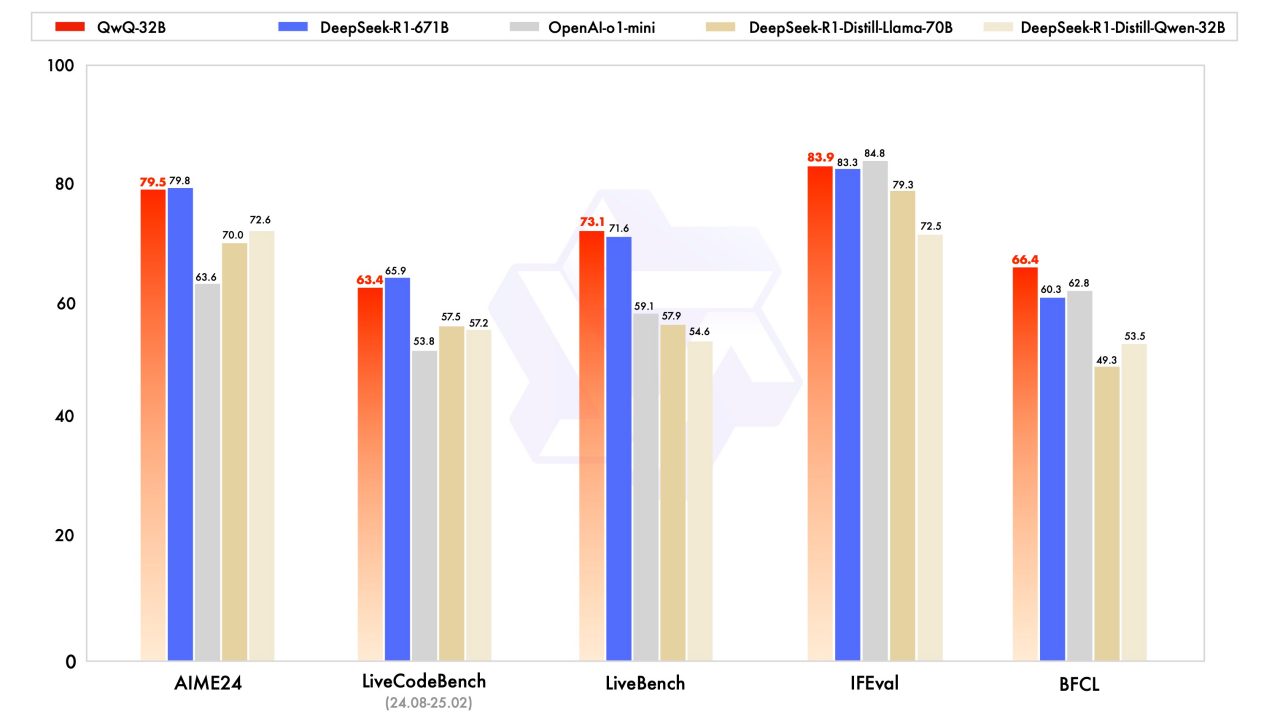

QwQ-32B 经过一系列基准测试,旨在评估数学推理、代码编写和解决一般问题的能力。从基准测试可以看出,该模型在能力方面表现良好。

另外 QwQ-32B 目前已经在 Apache 2.0 许可证下通过 HuggingFace 和 ModelScope 用户也可以通过开源 Qwen Chat 该模型用于平台。

博客原文:https://qwenlm.github.io/blog/qwq-32b/。

HuggingFace:https://huggingface.co/Qwen/QwQ-32B。

顶: 8497踩: 3991

顶: 8497踩: 3991

评论专区